IA e le nuove generazioni di lavoratori

Traduco per intero l’articolo di Romero https://substack.com/@thealgorithmicbridge

Ritengo sia un punto di vista realistico sulla IA e le nuove generazioni.

Sospetto che le generazioni più giovani abbiano commesso qualche peccato imperdonabile nelle loro vite passate. E questo è arrivato a perseguitarle. Una recessione finanziaria da cui non ci siamo ancora ripresi, la pandemia di COVID che ha trasformato i loro anni più preziosi in un lockdown forzato, niente figli, niente sesso, niente amore, niente amici, una crisi immobiliare che li spinge a rimanere con i genitori, una dilagante epidemia di ansia e depressione causata da un’invenzione che non hanno chiesto e a cui non possono sfuggire, l’incertezza dell’intelligenza artificiale che li stordisce e li preoccupa in egual misura, un altro mandato di Trump – su cui non ho commenti – e ora si scopre che non solo i lavori non pagano un reddito di sussistenza, ma non ce ne sono.

Derek Thompson, un giornalista acuto noto per aver diagnosticato i problemi moderni più urgenti – dall’antisocializzazione all’abbondanza all’intelligenza artificiale – è colui che potrebbe offrirci un’ipotesi migliore , perché se questa cupa prospettiva non è frutto di una forza ultraterrena, allora sono a corto di idee. Vediamo come risponde alla grande, grandissima domanda: perché l’occupazione tra i giovani laureati negli Stati Uniti è diminuita così drasticamente, al punto che la loro situazione è peggiore della media?

Passerò in rassegna le prime due cause da lui proposte, non perché siano irrilevanti o sbagliate, ma perché non ho nulla da aggiungere. La prima è che i colpevoli sono la Grande Recessione e il COVID: quello a cui stiamo assistendo è la continuazione di una tendenza che osserviamo da oltre un decennio. La seconda è che le lauree non valgono più tanto nel mercato del lavoro; l’investimento nella formazione non garantisce più un ritorno solido. Entrambe le ipotesi sono plausibili.

La terza causa, quella su cui ci concentreremo e che, suppongo, Thompson ritenga meritevole di maggiore attenzione, è che la colpa è dell’intelligenza artificiale: il mondo è già stato rimodellato da questa tecnologia ( anche se solo un po’ ), e ha deciso di iniziare, ovviamente, fregando i neolaureati.

Dare la colpa all’intelligenza artificiale per tutti i nostri problemi è praticamente un meme. I dazi stanno per distruggere il commercio globale e trascinarci in una nuova recessione perché gli stagisti hanno usato ChatGPT per elaborare la formula. Ieri sono caduto dalle scale del quarto piano perché stavo parlando con ChatGPT e non mi ha avvisato che c’era un gradino. Il tuo vicino, l’artista, non riceve commissioni da un decennio perché ChatGPT è stato lanciato due anni fa. Anche il tuo matrimonio, perennemente senza sesso, sta andando in pezzi, a causa delle ” fantasie spirituali ” che ChatGPT ha suscitato nel tuo partner.

Ora, i giovani sono senza lavoro e improvvisamente è l’IA a rubare loro il lavoro? Che fine ha fatto ” L’IA non ti ruberà il lavoro “? Ma Thompson, sempre attento ai dati, ha argomenti a profusione e un grafico dall’aspetto inquietante per convincerci:

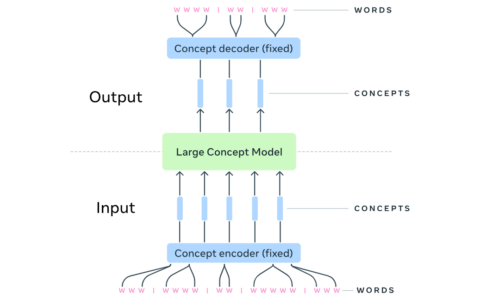

L’interpretazione più convincente di questo grafico è che si tratta esattamente di ciò che ci si aspetterebbe se gli studi legali sostituissero i giovani lavoratori con le macchine. Mentre gli studi legali si affidavano all’intelligenza artificiale per aumentare il lavoro paralegale, e le società di consulenza si rendevano conto che cinque ventiduenni con ChatGPT potevano svolgere il lavoro di 20 neolaureati, e le aziende tecnologiche affidavano la programmazione dei loro software a una manciata di superstar che lavoravano con copiloti di intelligenza artificiale, il livello di ingresso nell’economia dei colletti bianchi americana si contraeva.

Questa lettura coincide con quanto affermato dall’economista di Harvard David Deming a Thompson:

Quando si pensa, partendo dai principi basilari, a cosa può fare l’IA generativa e a quali lavori può sostituire, si tratta del tipo di attività che i giovani laureati hanno svolto. Leggono e sintetizzano informazioni e dati. Producono report e presentazioni.

Thompson ammette che tutte e tre le ipotesi sono valide e che la disoccupazione giovanile tra i più istruiti è probabilmente un effetto ibrido. Se dedica più tempo all’analisi dell’ipotesi dell’IA, è solo perché se ne scrive molto meno (o forse perché ne è un po’ di parte, non che lo biasimi). Riconosce anche, a suo merito, che altre fonti offrono un’interpretazione contrastante: forse l’IA non è nemmeno un fattore tra i tanti, ma in realtà non gioca alcun ruolo (per ora). Non c’è traccia nei dati di una “crescita di produttività sovralimentata” che l’IA alimenterebbe se l’ipotesi fosse vera (sono d’accordo, ne ho già parlato ), e la tendenza sembra estendersi fino ai primi anni del 2010.

Ma mi azzarderei a dire, facendo l’avvocato del diavolo contro me stesso, che il motivo per cui l’IA non compare nei dati potrebbe essere dovuto a due fattori che aiutano a evitare di scartare prematuramente l’ipotesi. Li nominerò qui. In primo luogo, l’IA è tanto uno strumento di produttività (lavoro migliore e più veloce) quanto un motore di distrazione (“aww, guarda quanto è carina quest’immagine che ha creato ChatGPT, passerò le prossime 4 ore a ghiblificare la mia galleria “). Forse l’IA non compare nei grafici di produttività perché un caso d’uso annulla l’altro in media, lasciando un risultato netto pari a zero. In secondo luogo, l’innovazione richiede tempo per essere adottata e diffusa, che si tratti di IA, Internet, telefoni cellulari o computer. C’è un ritardo tra il momento in cui l’IA inizia a sostituire i lavoratori e il momento in cui i guadagni di produttività iniziano a comparire nelle metriche.

Tuttavia, Thompson scopre, dopo aver svolto la sua due diligence, che ci sono ulteriori motivi per dubitare dell’ipotesi, oltre alla sua assenza dagli indicatori economici: “un sondaggio della Fed di New York sulle aziende, pubblicato l’anno scorso, ha rilevato che l’intelligenza artificiale aveva un effetto trascurabile sulle assunzioni”.

Se l’intelligenza artificiale non sta rallentando le assunzioni , allora non c’è molto altro da dire. Non è l’intelligenza artificiale la causa. Certo, resta la questione di come siano arrivati a questa conclusione: quando è stato condotto il sondaggio, dove e in quali settori? Un sondaggio condotto a maggio 2025 a San Francisco nel settore amministrativo potrebbe produrre risultati molto diversi da uno condotto all’inizio del 2024 nell’industria manifatturiera di New York. Tuttavia, i dati non offrono molto supporto e inventare scenari non testabili ha poco senso. Bisognerà aspettare.

II.

Ma dato che questo è un blog sull’intelligenza artificiale e sono ancora giovane – e anche se sono abbastanza fedele alla verità da non gonfiare un’idea che non abbiamo confermato – approfondirò un po’ di più l’effetto che l’intelligenza artificiale potrebbe avere sui miei giovani ragazzi. Forse Thompson non ha trovato prove sufficienti per confermare la sua teoria preferita, ma credo che la sua intuizione sia solida.

Concluderò quindi questo post con una riflessione: i nostri giovani laureati si trovano ad affrontare non uno, ma due handicap legati all’intelligenza artificiale che, purtroppo, si amplificano a vicenda, aggravando una delle grandi tragedie del mondo moderno: la perdita di potere delle giovani generazioni. In un mondo in cui il lavoro potrebbe alla fine essere completamente sostituibile dal capitale, è triste vedere questi giovani promettenti perdere il poco potere di negoziazione che forse avevano.

Dato che non voglio ferirti ulteriormente parlandoti tramite i tuoi genitori, insegnanti o datori di lavoro, ti parlerò direttamente. Credo che tu sia più che capace di ascoltare, ragionare e agire di conseguenza.

Il primo svantaggio è che molti di voi, che in passato si sarebbero sforzati di imparare diligentemente (volontariamente o no), ora stanno delegando quel lavoro all’intelligenza artificiale.

È facile darti la colpa o ritenerti responsabile – e capisco perché i tuoi insegnanti lo facciano – ma penso che sia giusto solo in parte. Cosa avremmo fatto noi, noi adulti ipocriti, al tuo posto? Siamo forse dei santi, in qualche modo? Non abbiamo anche cercato, ogni volta che potevamo, di evitare i compiti? Hai altre preoccupazioni, e dato il valore decrescente di una laurea (sì, contano ancora, non uccidetemi!), forse queste preoccupazioni sono in un certo senso più urgenti. Non è l’ideale che la tua istruzione venga rovinata, ma è altrettanto sbagliato che la società usi un doppio standard solo perché il problema in questione è doppiamente più grave.

Quindi, per principio, non sono contrario al fatto che tu scelga la tua strada. La società dovrebbe avere fiducia nei suoi studenti adulti come esseri autonomi in grado di prendere le proprie decisioni, giuste o sbagliate che siano. Ma credo valga la pena analizzare – se non affrontare direttamente – la misura in cui ognuno di voi potrebbe sviluppare una dipendenza malsana da questo strumento. Come qualsiasi altro, può essere incredibilmente utile, ma anche fonte di svantaggi mascherati da scorciatoie. Lasciare lacune nelle proprie conoscenze di base è un ingrediente chiave nella ricetta del fallimento professionale. Non è una condanna a vita, ma è un handicap a lungo termine.

Se i tuoi insegnanti continuano a suonare l’allarme, è perché è difficile rimanere impassibili mentre un’intera generazione di cui ti prendi cura decide di non diventare parte attiva di questo gioco collettivo che chiamiamo società. Hai dei diritti, ma hai anche dei doveri.

Passiamo al secondo handicap e concludo (hai ancora molto da studiare): ti imbatterai in un’IA già matura, già in grado di svolgere esattamente il tipo di lavoro di basso livello che tu, ancora senza esperienza lavorativa, normalmente faresti.

Se un compito è facile ed economicamente vantaggioso, l’IA lo affronterà per prima, spinta dalle forze del mercato e dalla tendenza ad accaparrarsi i frutti più facili. Questo è ciò che Thompson teme, e ciò che Deming ritiene inevitabile. Forse nessuna IA è in grado di gestire tutti i compiti (sono inaffidabili, incorporei, ecc.), ma quella piccola percentuale rimanente potrebbe essere svolta da qualcuno che ricopre già una posizione stabile nel mondo professionale.

Questa è una mia preoccupazione di lunga data : cosa sceglieranno le aziende: assumere lo stesso numero di stagisti e aumentare la produttività, o assumerne meno e mantenerla stabile? Nei settori in cui la domanda non può essere scalata a piacimento, la seconda opzione ha più senso. (Col tempo, l’automazione avrà la meglio , probabilmente nasceranno nuovi posti di lavoro e quelli vecchi verranno ridefiniti, colmando questo divario nelle assunzioni, ma sono profondamente preoccupato per la transizione ).

È giusto sottolineare che il primo handicap dipende da te e che, in effetti, se usi l’IA con saggezza – per imparare di più invece di meno – potresti trasformare quello squilibrio sfavorevole in un vantaggio. (Di nuovo: stai usando o3 per esplorare argomenti che non capisci, o 4o per fare film Ghibli?) Ma la verità è che le forze sociali che ti sballottano di solito operano ben oltre la tua percezione del mondo ancora in formazione. Ripenso a me stesso a 18 anni: un ragazzino ignaro preoccupato per la popolarità e le ragazze, senza una visione del futuro più chiara di “Farò quello che mi sembra più difficile”. La vita lavorativa era solo qualcosa che prima o poi sarebbe arrivata, senza fretta, e non sentivo di avere voce in capitolo. “Usare l’IA o no?”, avrei pensato. “Farò quello che fanno tutti gli altri”.

So che il paternalismo non aiuta, ma non aiuta nemmeno lasciarvi arrangiare da soli. Ciò che aiuta è un’istruzione adeguata e allineata al mondo in cui state per entrare. Ogni scuola superiore dovrebbe implementare un’introduzione all’intelligenza artificiale e una guida su come orientarsi nel mercato del lavoro. È difficile: le lezioni importanti cambiano ogni mese, non esiste un manuale aggiornato regolarmente e, beh, è qualcosa che stiamo cercando di capire tutti contemporaneamente, ma il fatto che sia una sfida formidabile non la rende meno importante.

Ecco perché non dico che si tratti di autolesionismo (anche se alcuni vogliono definirlo così), ma di una tragedia. Non posso giudicarvi con criteri più elevati di quelli a cui noi vecchi ci siamo attenuti. Quindi non prendetelo come un sermone o un rimprovero. È un avvertimento. Un invito all’azione. Per chi di voi aspetta un deus ex machina , sappiate questo: il mondo non è stato completamente automatizzato, né è stato istituito un reddito di cittadinanza universale, quindi temo che nessuno verrà a salvarvi.

Mi dispiace per te, ma ho anche fiducia che troverai la tua strada.

Eppure, non posso fare a meno di chiedermi quale peccato imperdonabile qualcuno abbia commesso in una vita passata per avere così tanta sfortuna in questa. A nome di una società che vi accoglie con così poca ospitalità: mi dispiace.